自然語言處理主要的挑戰,在於要建立一個可使用全世界7000多種語言的系統,大多數的語言都缺乏資料沒辦法單獨訓練出一個足夠厲害的模型。不過幸運的是,有許多語言都有著許多相似的基礎結構或是來自同一個來源,我們透過多語言 AI 模型學習,在訓練中克服資料不足的問題。

世界上共有超過7000種語言,而其中接近3000種語言處於瀕危狀態,如果為每一種語言都打造一套獨立的語言模型,那所需要的資料庫以及開發的工程都將無比巨大[1]。 多語言AI模型能夠學習不同語言之間的相似之處,在有限的資料下學習多種語言。這樣的特性除了能協助保存流逝中的冷門語言,也讓科技巨頭能夠在打入更多語言市場的時使用更少的資源。市場預計在2023年將有80億個智慧語音助理被人們使用,但這些語音助理多只支援主流語言[2],而多語言AI模型能夠為語音助理的開法者在開拓市場時省下大把的時間與鈔票。

多語言AI模型透過學習不同語言間的相似之處,從資料充足的主流語言中汲取語言學的知識再轉移到資料稀缺的冷門語言中。 如此將知識套用到另一個語言上的概念稱為遷移學習(Transfer Learning)。遷移學習可以處理龐大的未標記資料並降低訓練成本。當我們僅有少量標註資料而無法訓練機器學習模型時,可以從已有或公開的大型標註資料集裡將其他開發者訓練好的演算法套用在自己的模型上,再針對我們要的方向優化調教來獲得更好的結果。這些事先訓練好的模型稱為預訓練模型(pre-trained model)。有名的 BERT 就是 Google 所開發出的預訓練語言處理 AI,在許多競賽中都可以看到選手以 BERT 為基礎進行開發並取得優異的成績。通常預訓練模型沒辦法完整的解決特定問題,但能為開發者省下開發基礎功能的大量時間,轉而專注在提升模型於特定領域的表現。

而多語言AI之所以能套用遷移學習,是因為儘管文字與文法不盡相同,不同語言間仍有許多相似之處讓機器學習模型可以重複利用。舉例來說,比起「飛機」,「運動」這個單字更常與「慢跑鞋」出現在同一個句子當中,當我們用英文訓練模型學會這個知識後,就可以透過已知的字典對照讓模型在資料相對稀缺的客家語中也運用相同的知識。這些被機器學習所抓出的語言之間共通特性稱為 general-purpose multilingual representations。

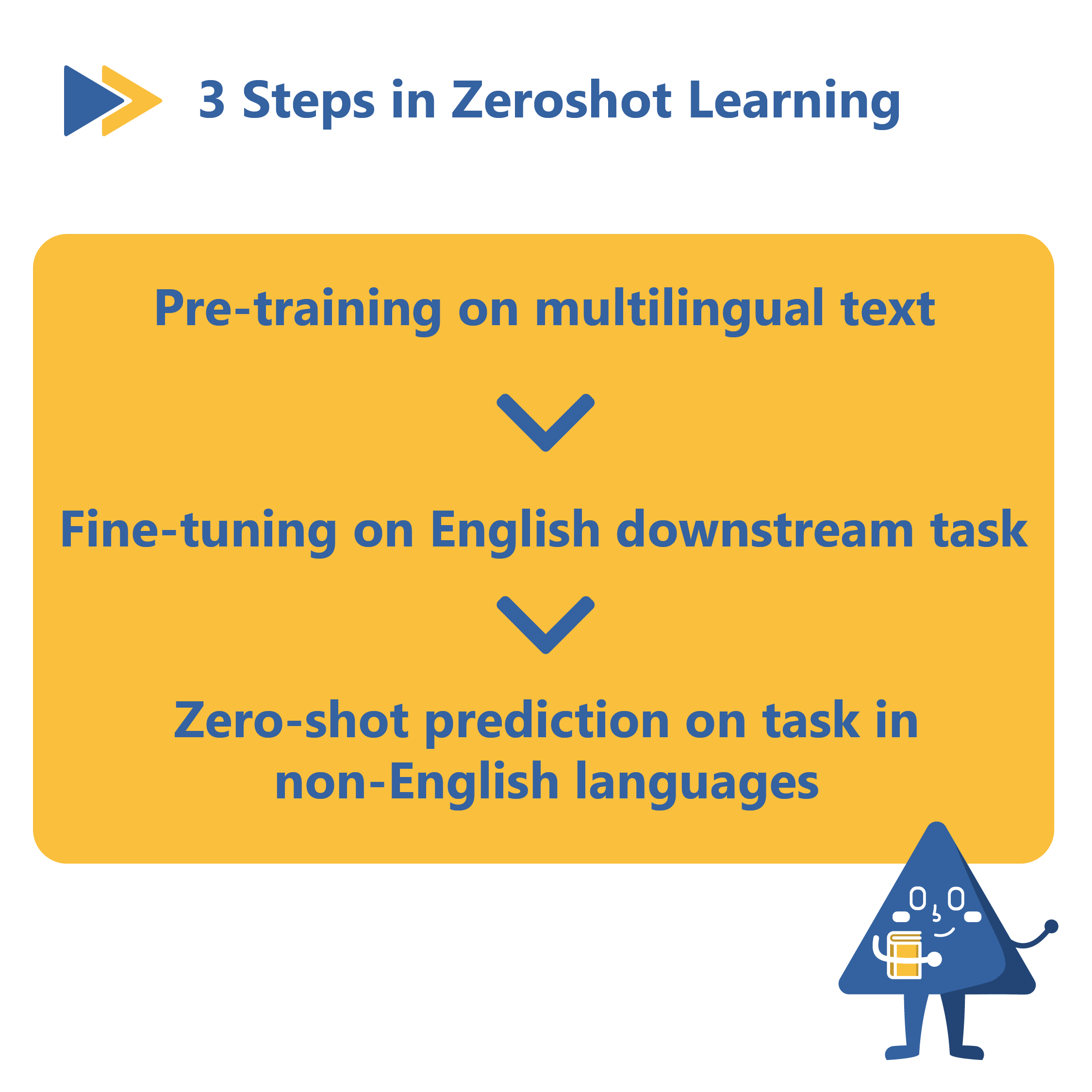

Google 在 2020 年所發表的XTREME(巨大多語言多工模型)將遷移式學習推向另一個極致 - 零樣本學習(Zeroshot Learning)。加入零樣本學習演算法後,預訓練模型只需要針對語言任務(例如判斷語氣或回答問題)在主流語言上進行微調後,就可以直接在其他語言上執行任務[3]。 圖一[4]展示 Google 在 XTREME 上先透過預訓練在泰文、日文及英文上進行詞彙訓練,再利用英文資料庫針對評斷任務進行優化調整,最後套用零樣本學習法讓泰文及日文對從未看過的句子進行評斷的任務。

(圖一)

在 XTREME 的零樣本學習過程中,科學家利用訓練對答、克漏字、語氣辨識等不同任務的訓練讓模型能夠更全面的學習不同語言。而除了透過不同任務來加強 AI 對語言的理解外, IBM 針對語言之間的轉換更進一步的使用資料增強(data augmentation)來擴張訓練英文資料集,再套用語言仲裁框架(language arbitration framework)檢驗模型在對答任務上的合適程度並配合對抗式訓練(adviserial training)不斷精進問答的運算結果,讓 AI 在只訓練於英文資料集上就能提升語言轉換的運算成果[5]。

產學兩界皆投注了大量的資源在收集資料庫與開發演算法,目前廣泛被使用且已公開的多語言 AI 資源有:

XTREME by Google

Google 所發布的自然語言處理系統基準測試 XTREME提供涵蓋40種語言的9項語言任務。在英語資料集訓練後於其他語言上通過對語言、語法以及語意推理等任務後評估效能。

FLORES 101 by Meta

Meta AI 的 FLORES 101 共有101種語言,專門作為翻譯使用的資料庫,以及可以雙向翻譯100 種語言的翻譯模型 M2M-100。

MASSIVE by Amazon

Amazon 於2022年4月公開的資料庫包含了 51 國語言以及超過 100 萬句的語音資料。未來也將舉辦基於這個資料庫的競賽以及工作坊。

Multilingual-BERT by Google

基於Google所開發的BERT模型上延伸,從 104 種語言的單語語料庫進行預訓練,在零樣本跨語言學習中有出色的表現。

隨著越來越多研究者和科技龍頭投入多語言模型的研究,並且陸續地有珍貴的資料庫及演算法被開源使用,未來語言之間的隔閡將會越來越薄,機器學習將為人類的溝通帶來躍進的貢獻與保存珍貴的文化資產。