在這篇文章中,我們會介紹從未有人嘗試過的研究:利用fMRI數據來預測、判斷大腦對人臉辨識的能力。

這裡談及的臉部辨識能力包括判讀表情,對人臉的記憶等等。而人與人每一天的互動與社交,都牽涉到臉部的辨識:取得他人的行為資訊,轉譯並理解,做出反應。但如果連取得資訊都有困難,可能會對一個人的社交生活造成很大的障礙。無論是「白目」、「臉盲」還是「不會讀空氣」,或許這些不懂得察言觀色的朋友,他們不是故意的,他們是天生的!

1997 年,神經科學家 Nancy Kanwisher 發現,腦袋中有部分區域似乎專門負責辨識人臉。而推進這個研究的原因之一就是 fMRI 功能性磁振造影技術,透過感測血流量,非侵入的監測大腦中的神經活動。

當今科學家也持續投入大量的心力,利用 fMRI 技術研究腦神經科學與人臉辨識的關係,然而,還沒有人嘗試過直接以 fMRI 數據來預測每個人臉部辨識與記憶能力。不過在 BIIC Lab,當 fMRI 帶來了大量數據,就輪到機器學習登場了!

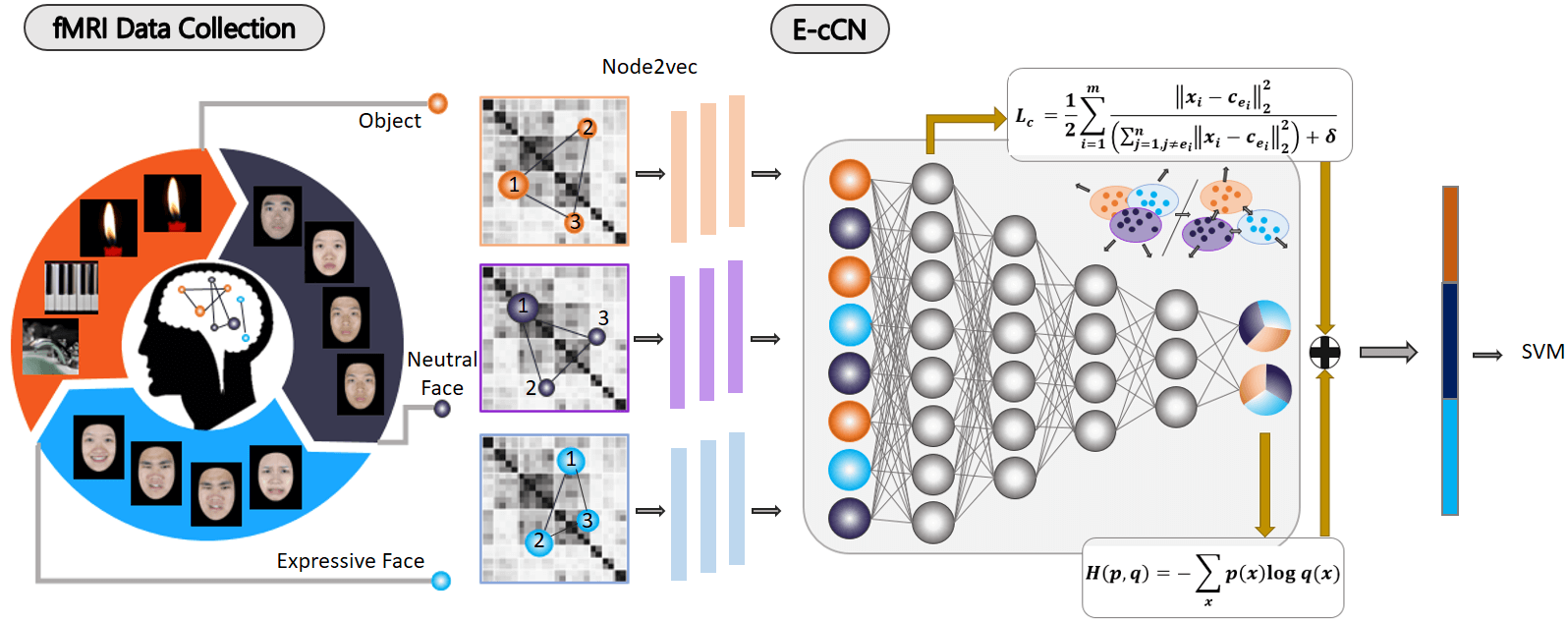

本次由 BIIC 實驗室的謝宛庭與中正大學心理系合作,她提出「事件對抗腦神經連結網路(Event-contrastive Connectome Network,E-cCN)」,利用讓實驗對象同時面對三種事件—中性表情人臉、激烈表情人臉、物體—來蒐集更充分的 fMRI 資料。

另外,宛庭也在本次的實驗中,嘗試了不同的「網絡表示學習(Network Representation Learning,NRL)」方法。除了圖片、文字、音訊等數據形式以外,還有一種數據形式是「網絡」,例如本實驗的 fMRI 數據資料(也就是腦神經網絡)、社交網絡。舉例而言,人和人的關係有親疏遠近之別,這個同學和那個朋友可能也互相認識,而大學朋友又自成一群等等等。

(圖:複雜的社交網絡 (。ŏ_ŏ))

這樣網絡結構的資料難以直接數字化,因此,倘若要在機器學習的工作中使用這些數據,需要先將網絡結構數據進行處理,將其轉換為向量資料,讓網絡之間的連結更明顯、對比更分散。而處理的方式就稱為「網絡表示學習」。宛庭以本次的 fMRI 資料比較不同的處理方式,找出或許最適合臉部辨識的「網絡表示學習」。

首先!我們在教機器寫考卷之前,要先準備答案!所以,招募來的44 位志願者先進行兩個測驗,分別是「台灣人臉記憶測試(TFMT)」和「component task」,藉此宛庭可以得到受試者們的人臉記憶及辨識能力分數。

接著,中正大學心理系的研究人員提供宛庭一份「感興趣區域(RoI)」,內容指出左右腦中可能與人臉辨識較為有關的神經區域,包括大家常聽見的海馬迴、杏仁核等等。

好的,接下來要請受試者進到機器裡面去了。如果你有做過核磁造影的話應該會覺得自己像電影主角一樣,接下來不知道會發生什麼事。可惜在這個實驗中沒那麼刺激。實際上,受試者躺在fMRI 機器裡面,看著螢幕上顯示的圖片,到底是中性表情的臉、還是激烈表情的臉、或是物體呢?如果和前一張照片顯示的是同一類型,就按一下旁邊的按鈕。

(圖:Keroro 軍曹動畫中喜歡「按下去~」的 Kururu)

以此方式進行 6 組「中性表情人臉/激烈表情人臉/物件」測試,宛庭就是利用這個測驗中的 fMRI 數據來分析並建立模型!

第一階段,宛庭將計算機視覺領域中的概念轉換到研究中,對數據進行「contrastive-loss」調整,用一個神經網絡將三種事件的資訊跟所得到的腦訊號向量結合,讓來自相同事件刺激的訊號能夠聚集在一起,不同刺激的則分開。方法則是計算出觀測的腦區兩兩之間的皮爾森相關係數。如此一來,可以讓腦區之間有功能性連結——即標記出同時工作的腦區為相連——,每一筆數據產生的特徵也會更有意義。然而這樣調整也有可能造成誤差,所以之後宛庭也利用「交叉熵, cross entropy loss」,意思是利用最後的結果來驗證資料,之後再依需求調整 contrastive-loss 神經網絡。

宛庭使用的架構包含了上述的 contrastive-loss 神經網絡,以及五層的深度神經網路 Deep Neural Networks(DNN)。首先先收集單一事件(如:物體、中性臉譜、情緒臉譜)下的腦訊號,並經過不同的「網絡表示學習」方法,將腦訊號向量化後再輸入架構中,將得到的結果以 TFMT 和 component task 兩個測驗的分數來進行驗證。

(圖:本實驗的架構圖)

不同的網絡表示學習方法,包括了 DeepWalk 、 LINE 、 Node2Vec 等等,其中最常在社群網路領域使用的是Node2Vec,這次實驗也證明使用 Node2Vec 可以讓機器學習後的辨識準確率最佳,是最適合用來處理數據的網絡表示學習方法。

最終,可從下表中看到機器學習後的辨識結果,可看見在「物體事件」中可以達到 74.95%、甚至 79.27% 的辨識準確率,而更值得注意的是,將三個事件的特徵向量混合處理後,可以達到 80.2% 、 82.05% 的辨識準確率!

(圖表:將兩項測驗的 fMRI 資料經由左欄不同的網絡表示學習方法學習出的準確率)

既然證明了這套架構能夠用於預測人腦的臉部辨識能力,那麼在科學上,是否也與之前的研究結果相符呢?

宛庭將實驗中得到的腦神經訊號取出的特徵向量轉換為矩陣,再計算感興趣的腦區與腦區之間的相似度,研究他們工作的相關程度,保留高相似度的邊,形成面對刺激時產生反應的腦網路。最後,發現確實 OFA(occipital face area ,枕葉臉孔區)和 FFA(fusiform face area ,紡錘臉孔腦區)具有特別高的相關性,也是過去相關論文中人臉辨識的關鍵腦區!

在這個實驗中,測驗表現較佳的受試者如預期一般,上述兩個腦區會在實驗中同時活動;測驗表現較差的受試者則是在辨認表情時關鍵的腦區,如 FFA 會較無反應,記憶功能差則可能是因為大腦關鍵的臉部處理和記憶區塊兩者之間的連接功能較低。

這次的實驗最後相當成功,宛庭提出的 E-cCN 方法優於現行的評估方式,透過這個對比性事件自動化評估神經連結的臉部處理與記憶能力,未來也有更多發展的可能性,也讓我們對人類的大腦又多了一些了解!

那麼你讀完了是不是也想知道自己的臉部辨識能力呢?首先你要先去進行 fMRI 測試,宛庭可能會願意幫你評估看看……開玩笑的,試試看這個格林威治大學作的 臉部辨識小測驗 吧,不過臉盲也別太煩惱,畢竟迷人的布萊德彼特也是 臉盲!

本文授權改寫自碩士生謝宛庭 2019 年於 ICASSP 發表的論文:

Wan-Ting Hsieh, Hao-Chun Yang, Fu-Sheng Tsai, Chon-Wen Shyi, Chi-Chun Lee, "An Event-Contrastive Connectome Network for Automatic Assessment of Individual Face Processing and Memory Ability", in Proceedings of International Conference on Acoustics, Speech, and Signal Processing (ICASSP), 2019

(圖:BIIC Lab 碩士生謝宛庭,攝於 SP·ARK)