「the study and development of systems and devices that can recognize, interpret, process and simulate human affects.」——Professor Rosalind Picard, Affective Computing, 1995

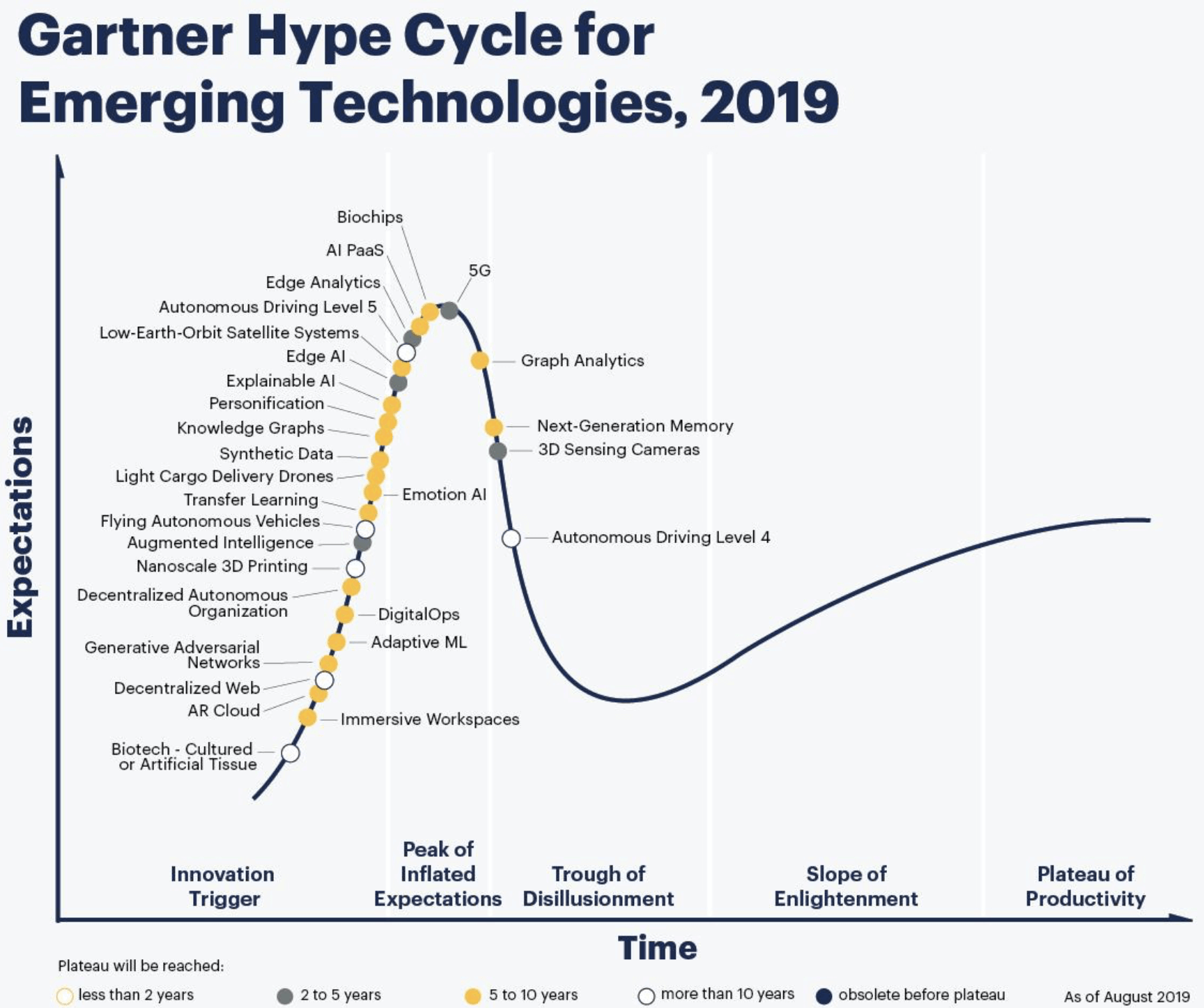

情感運算正當紅,國際調研機構 Gartner 也指出,emoiton AI 是趨勢中最值得注意的新興科技,並預測其會在五到十年內高度發展。事實上,情感運算已日漸走入大眾生活,而未來,將只會更加普及。本文將介紹情感運算的起源、研究與發展,希冀能讓情感運算更加廣為人知。

圖片來源:Gartner

1990 年,Rosalind Picard 教授來到麻省理工學院媒體實驗室,進行圖像壓縮技術的研究。然而,她很快就遇到瓶頸。此時,Picard 教授想到,若機器能夠分辨圖像內容再進行壓縮,那麼就可以改善模型了。但這需要讓機器擁有視覺的能力,區別內容的能力,她因此開始深入了解大腦與神經科學。很快,她一頭栽進情感研究的世界。[1]

1995 年,投身於情感與運算的Picard 教授,拒絕了一筆用於圖像壓縮的龐大研究資金,發表《Affective Computing》一書,在她自己都未預料到的情況下,開創了計算機科學的分支:情感運算。

幾年間,Picard 教授建立起情感運算的研究範圍,包括分類模型(如何分類情感?)、連續模型(如何度量情感?)、檢測與識別情感,甚至是進一步的,讓機器擁有情感。

這個跨學科的領域包含了心理學、認知科學、計算機科學,人們期待著機器能夠了解人類的情緒,並給出適當回應。

然而,直到近二十年,情感運算才因為機器學習、訊號處理等技術成熟後,受到大量矚目。

說到訊號處理,不能不提南加大的 Shrikanth Narayanan 教授所提出的行為訊號處理(BSP):「行為訊號即是行為可觀察的部分」,例如表情、聲音、身體姿勢等等,透過機器學習及現今的技術分析、整理這些訊號,再進一步應用。

而將數種行為訊號進行處理,就是「多模態訊號處理」,這個方法能夠更全面的分析人類的行為,提升了情感預測、辨識的準確度,推進情感運算的研究前線。

研究走在科學的最前端,也是未來科技普及至大眾生活的風向球,不妨透過當今幾個知名的研究單位,了解情感運算的發展方向!

以上簡單介紹幾個研究單位,如果想了解更多,推薦讀者們參考國際先進情感運算協會(AAAC),或是可以追蹤這些研究單位的 twitter、臉書,了解最新趨勢!

除了國外的研究者,台灣其實也有不少研究單位,從不同的角度切入,深耕情感運算領域,更陸陸續續將情感運算應用在生活中,以下簡單介紹幾位 BIIC Lab 的研究同伴,也期待更多情感運算的研究,能在台灣遍地開花。

聊了這麼多研究,研究是終究要走入生活之中,最後,我們透過現今情感運算的應用、發展與相關議題,讓未來的想像更加立體!

調研機構 Gartner 2018 年發表了文章《13種情感 AI 技術的應用》,既是為情感運算的未來勾勒一張藍圖,也是印證這幾年間情感運算研究在世界各地的應用,如今世界變動如此快速,像情感運算這樣發展快速的科技,是未來也是現在!

文章中提到了電玩、醫療診斷、教育、勞動安全、護理、駕駛安全、自駕車、測謊、招聘、客服、物聯網、公共服務、零售消費等應用方式,其中有不少在今天已經實現,例如 Nuance 透過辨識、分析臉部表情與聲音,協助駕駛在穩定的情緒下安全駕駛,但也有如自駕車,現今尚未完全實現自動駕駛,遑論透過情緒辨識給乘客不同的自駕體驗。

而目前應用較為普遍的醫療、招聘,也都成為情感運算的熱門議題。在醫療方面,透過各種各樣的情感運算,來協助不同的病患維持生理與心理的健康,大眾的接受度較高;然而在招聘方面,許多面試者表示,面對 AI 而非真人面試,讓他們的感到相當不安,網路上也出現許多「AI 面試攻略」,反之企業則表示利用 AI 面試,大大降低了招聘成本,看來 AI 招聘的利弊與發展還有待觀察![2]

另一方面,利用情感運算的客服、零售消費甚至是公共服務,或許正悄悄走進大眾的生活。不論是文字、語音的客服,越來越多企業整合進情感運算,提供更好的消費體驗;而零售消費則是在商店中,安裝攝影機分析消費者分不及情緒反應;英國政府在社群媒體上利用文字分析大眾對公共議題的情緒動態,而阿聯酋則是在公共場所裝上攝影機,了解人們總體情緒,希望讓國民更加幸福。

情感運算的應用在普及的過程中,最大的障礙不外可信度和隱私。可信度有賴於嚴謹的研究規範,以及更多平等的意識,以避免歧視,也有研究者公開呼籲政府監管情感運算應用,讓研究領域更加穩定,並保護消費者。而大眾也開始接受更多元的隱私訊息分享,例如公開分享自己運動的歷程、生理紀錄,但在情感運算多元的資料中,究竟如何被使用是可接受的,還有賴更多的社會討論和政府規範了![3]

期許國際社會及台灣政府,都能夠加速對新興科技的了解與管理,也希望這篇文章能讓各位讀者對情感運算更加了解,我們下次見!